Me pregunto si Estados Unidos, ahora que estará gobernada por los gigantes tecnológicos, tendrá en cuenta principios tan básicos y fundamentales en una democracia como son el derecho a la igualdad, a la dignidad humana, la no discriminación, la protección de datos, la transparencia y al derecho al consentimiento informado, en el uso de los sistemas de Inteligencia Artificial y robótica.

Mis dudas surgen porque hay quienes piensan que, una regulación que garantice estos derechos, implica poner trabas a la innovación, al avance tecnológico, cuando en realidad nos está garantizando disponer de una inteligencia artificial fiable que ofrezca seguridad y confianza a los ciudadanos. De hecho, si aplicamos las mismas leyes de la robótica de Asimov, éstas priorizan la seguridad de los seres humanos estableciendo la máxima que:

“Un robot no puede dañar a la humanidad, o por inacción, permitir que la humanidad sufra daños”.

Daños que también se producen, obviamente, si atacan o perjudican directamente a nuestros derechos fundamentales y a nuestros valores humanistas que si bien son intrínsecamente europeos, son universales. Valores que se caracterizan por la contribución de Europa a la sociedad.

La aplicación de estas normas o principios, como digo, no deben afectar, en absoluto, al proceso de investigación, innovación o al desarrollo en el ámbito de la IA ni de la robótica, sino más bien contribuyen que la innovación sea de calidad, más avanzada y se distribuya de la manera más amplia evitando riesgos e inseguridades, sin que nos olvidemos de que la IA debe estar al servicio de la humanidad.

Así pues, una de las obligaciones que de hecho contempla el Reglamento de Inteligencia Artificial (RIA) aprobado en Europa para evitar que el empoderamiento tecnológico lesione nuestra seguridad, es el principio de transparencia que permite siempre justificar cualquier decisión que se haya adoptado con la ayuda de la IA, y que pueda tener un impacto significativo en la vida humana para evitar, de esta manera, riesgos específicos de manipulación. De hecho, a los mismos usuarios de un sistema de IA que genere o manipule contenido de imagen, sonido o video que se asemeje a personas, , objetos, lugares o sucesos, que puedan inducir erróneamente a una persona a pensar que son auténticos, deberán hacer público que ha sido generado de forma artificial o ha sido manipulado.

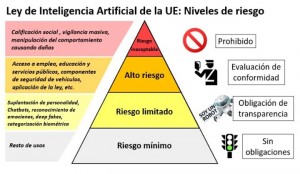

Por otro lado, hay que aclarar que no todos los sistemas de IA se les exige las mimas obligaciones y controles, sino que, concretamente, las más estrictas son aplicables a las de alto riesgo como las que se refiere el artículo 6 del Reglamento de IA como el acceso a empleo, educación, servicios públicos, etc. Es por ello por lo que se les obliga a tener una supervisión humana regulado en el artículo 14 RIA que tendrá por objeto prevenir o reducir al mínimo los riesgos para la salud, la seguridad o los derechos fundamentales, además de requerir una vigilancia de mercado a través de la cual se realice un seguimiento posterior a la comercialización por parte de los proveedores para recabar y analizar datos proporcionados por los usuarios o recopilados por otras fuentes. Cualquier incidente grave o fallo de funcionamiento debe ser notificado a la autoridad de vigilancia de mercado donde se haya producido el incidente.

En cuanto aquellos sistemas de IA que afecten al comportamiento y técnicas deliberadamente manipuladoras o engañosas, con el objetivo o el efecto de distorsionar materialmente el comportamiento de una persona o de un grupo, vigilancia masiva, puntuación social , directamente son calificadas como prácticas prohibidas y por tanto, inaceptables según prevé el artículo 5 de RIA.

En el siguiente esquema vemos los niveles del riesgo de cada IA y el grado de responsabilidades en función de la finalidad que persiga.

Si bien es cierto que, para aquellos sistemas de IA que no generen riesgos (gestión de datos o la automatización de procesos administrativos etc.) o sean limitados como aquellos que interactúan con las personas, como chatbots y asistentes virtuales, no están sujetos a un control exhaustivo ni a una evaluación de conformidad, sí que se fomenta que apliquen de manera voluntaria ciertos códigos de conducta regulado en el artículo 95 RIA como minimizar el impacto de los sistemas de IA en la sostenibilidad medioambiental, prevenir el impacto negativo de los sistemas de IA sobre las personas o grupos de personas vulnerables, también en lo que respecta a la accesibilidad para las personas con discapacidad, así como sobre la igualdad de género.

Teniendo en cuenta todo lo que nos ofrece disponer de una regulación adecuada en materia de IA y en robótica como es la mediación de una supervisión humana para disfrutar de una IA fiable, como es la posibilidad de que nos permita impugnar las decisiones automatizadas tomadas por la IA que afecten a nuestra esfera personal y patrimonial, como es tener la garantía de que no se menoscaben nuestros derechos fundamentales como la igualdad, la justicia, la no discriminación, y al derecho de ser informado debidamente; acaso todas estas obligaciones ¿implican frenar la innovación?, o lo que pretendemos no es sino que ¿tener como principal objetivo que la revolución tecnológica esté al servicio de la humanidad evitando con ello posibles riesgos para nuestra seguridad, salud, integridad y libertad?.